Sự phát triển của AI đang kéo theo nguồn điện cung cấp trong quá trình xử lý và làm mát gia tăng chóng mặt, đòi hỏi những hệ thống quản lý năng lượng hiệu quả.

Những hệ thống tiết kiệm năng lượng trong máy chủ AI và tầm nhìn của Schneider Electric trong phát triển giải pháp quản lý năng lượng.

Theo dự báo của Cơ quan Năng lượng Quốc tế (IEA), vào năm 2030, điện năng tiêu thụ của các trung tâm dữ liệu trên toàn cầu có thể vượt mốc 945 TWh, gần gấp đôi so với hiện tại. Với tốc độ phát triển thần tốc của các mô hình AI như ChatGPT, các trung tâm dữ liệu đang phải gồng mình chạy đua để không bị tụt lại, nhưng chi phí năng lượng và áp lực vận hành đang ngày càng chạm ngưỡng báo động.

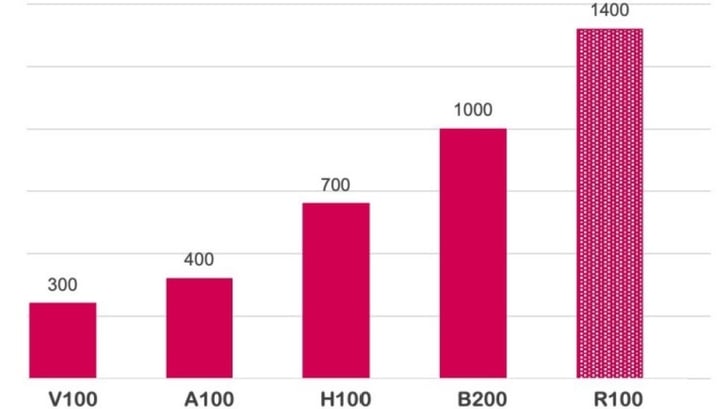

Các dòng chip với hiệu năng lớn hơn và hiện đại hơn cũng đòi hỏi lượng điện tiêu thụ và hệ thống làm mát công suất ngày càng cao hơn, với thế hệ sau có thể cao hơn từ 30 – 75% thế hệ trước.